近日,中國科學院合肥物質院安光所光電子中心計算機視覺團隊研發出適用于大場景的多機器人協同定位新技術。相關研究成果發表在機器人領域國際Top期刊?IEEE Robotics and Automation Letters (IEEE RA-L)?上。

在智能機器人領域,基于視覺的同步定位與地圖構建技術(SLAM)因視覺傳感器具有成本低、部署靈活、信息量豐富等優勢,成為行業研究熱點。在大規模環境中,通過共享地圖數據實現協同作業可大幅提升工作效率。然而,實現多機器人系統中不同機器人間的全局定位(Multi-Robot Global Localization, MR-GL)依然面臨諸多挑戰。特別是在機器人初始位姿未知、環境動態變化劇烈的情況下,不同機器人間視角差異造成的數據數據匹配困難,動態場景對算法的實時性與魯棒性(一個系統在面臨著內部結構或外部環境的改變時也能夠維持其功能穩定運行的能力)提出了更高要求。此外,如何在保障精度的同時快速完成多機協同定位,是影響協同任務能否成功執行的關鍵因素之一。

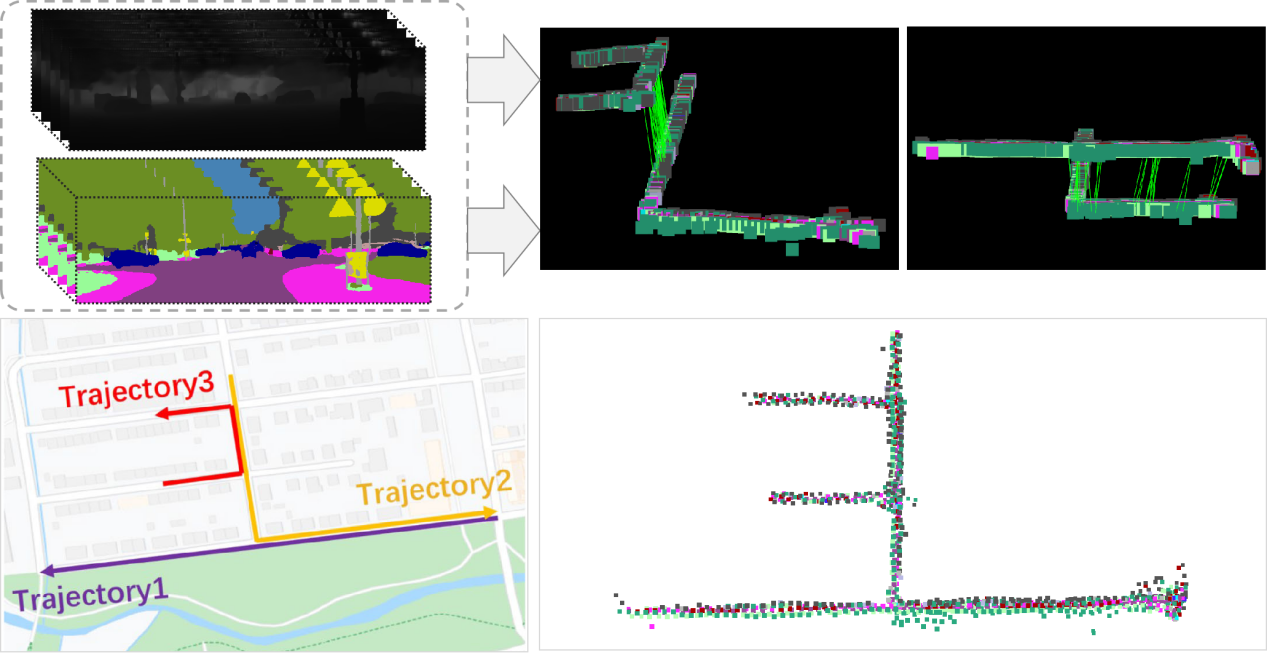

針對上述難題,研究團隊創新性地提出了一種融合語義與幾何三重約束的圖匹配多機器人全局定位方法——SGT-MGL。該方法首先提取場景中對象的語義與幾何特征,并通過拓撲結構刻畫其空間分布關系。為增強對象的區分性,研究人員基于語義信息與相對距離構建了三角形描述符,進一步提升了特征辨識度。考慮到語義與幾何信息的互補特性,創新性提出了一種融合語義標簽、空間夾角及相對距離信息的三維直方圖描述符,有效提升了三角形描述符的穩定性與不變性。為進一步降低噪聲干擾,研究團隊采用"由粗到精"的匹配策略,提出了一種由全局幾何結構篩選關鍵點位,并結合局部與全局圖匹配方法,實現了多機器人間的高精度六自由度(6-DoF)(三維位置+三維朝向)姿態估計。實驗結果表明,該方法在提升全局定位精度方面具有顯著優勢。

實驗數據顯示,該技術在復雜動態環境中的定位精度較傳統方法提升顯著。其創新性的三重約束機制,既保證了算法在視角差異下的魯棒性,又通過分級處理兼顧了運算效率,為未來智能醫院、智能工廠等場景的多機器人協同作業提供了關鍵技術支撐。

該項工作的第一作者為王凡博士后,通訊作者為張文副研究員和劉勇研究員。本研究得到了國家自然科學基金、合肥物質院院長基金和國家重點研發計劃的支持。

文章鏈接:https://ieeexplore.ieee.org/document/10924764

圖??多機器人全局定位方法在KITTI08序列數據集上的應用

<span id="9mlez"><optgroup id="9mlez"></optgroup></span>